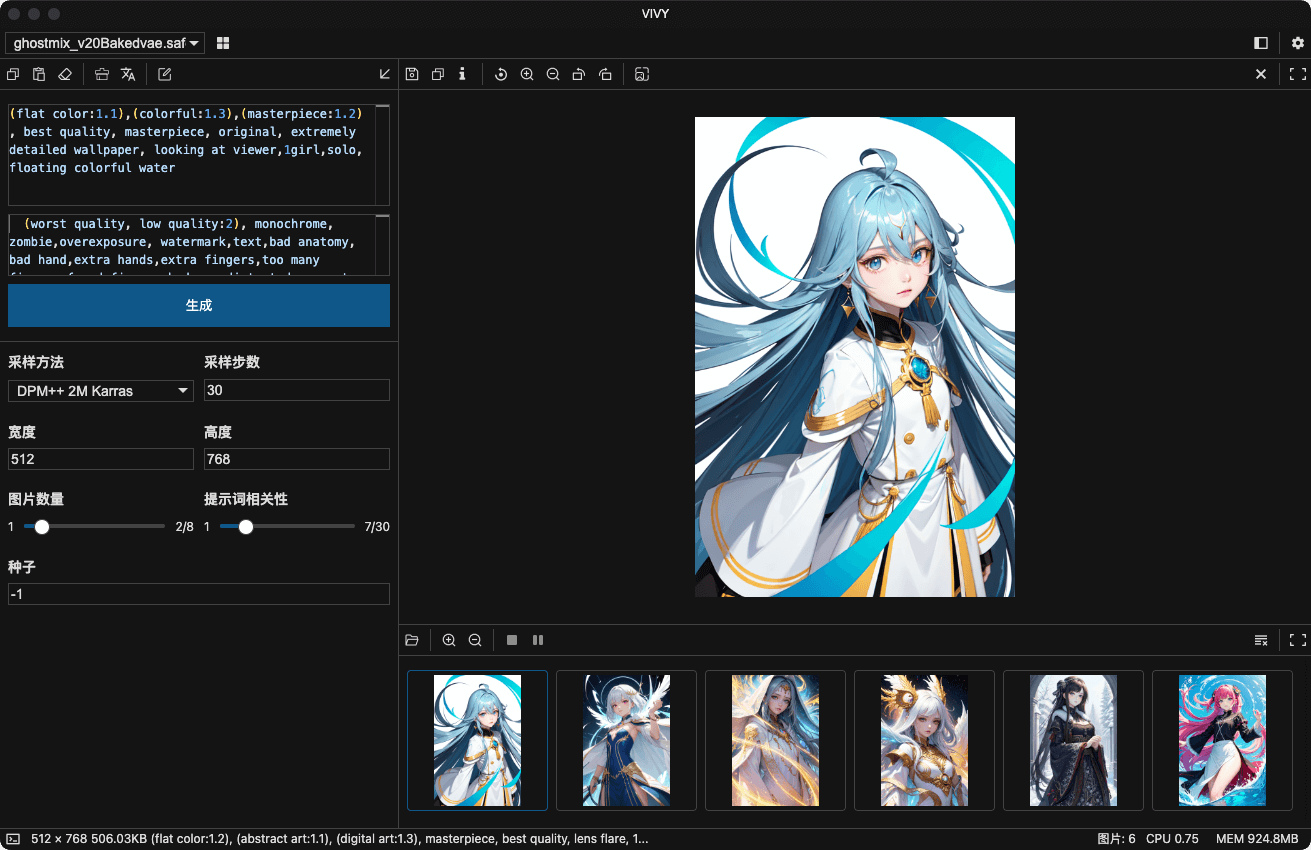

Stable Diffusion Prompt Reader v1.3.5

一个独立的简易 AI 图片 prompt 查看器,用于在不依赖 webui 的情况下提取由 Stable Diffusion 生成图片内包含的 prompt 不需要任何额外环境 /命令行 /浏览器,双击 app 把图片拖入即可

有任何建议或者使用问题请告诉我

Github Repo | 简体中文

一些题外话

前一段时间有许多内容创作者主动用不同语言撰写和制作介绍和推广相关的文章和视频,说真的我很震撼。最近主 repo 的 stars 也快 1k 了,十分感谢大家的支持。

我其实很好奇国内的正经 Stable Diffusion 社区究竟在哪儿,感觉我能找到的那些全都非常封闭,更新也不太及时。基本就是把外面东西搬运一下做个整合包写个教程之类的。而且材料也都是 A1111 相关的,很少有 ComfyUI 这些的相关的东西。如果有群或者社区平台请务必告诉我,非常感谢。

前几个版本都没有在 V2EX 发主要是因为中文用户比较少,加上没有添加特别重要的新功能。具体的 changelog 可以看release (虽然没写中文版)

另外,大家可能不太相信,但这个 GUI 确实是 Tkinter 写的,为了能做到这个美观度我真的废了好大的劲。主要用了 CustomTkinter ,部分模块自己魔改了一下。配色用的是苹果的 guideline ,功能图标是谷歌的 Material Symbols ,app 图标是用 SD 生成的。至于为什么不用 Qt 写,qml 在我的 Mac 上会有迷之 bug ,而且几个打包工具作者对 PySide 的支持比较迟缓 (提的 issue 等我用 Tkinter 写完之后全修复了..感觉自己像个怨种)。有兴趣的话可以看一下代码,但是个人强烈建议千万别用 Tkinter 写任何东西,里面全是坑。

重要更新

功能

- 支持 macOS 、Windows 和 Linux

- 提供图形界面和命令行两种交互方式

- 简单的拖放交互

- 复制 prompt 到剪贴板

- 去除图片中的 prompt

- 导出 prompt 到 txt 文件

- 编辑或导入 prompt 到图片

- 竖排显示以及根据字母排序

- 检测生成工具

- 支持多种格式

- 支持系统深色和浅色模式

支持格式

* 见格式限制.

如果你使用的工具或格式不在这个列表中, 请帮助我支持你的格式: 将你的工具生成的原始图片文件上传到 issues, 谢谢.

对于 ComfyUI 用户,SD Prompt Reader 现在可作为 ComfyUI 节点使用。 ComfyUI Prompt Reader Node 是本项目的一个子项目,建议在你的工作流程中嵌入其中的 Prompt Saver node 以确保最大的兼容性。

下载

Windows 用户

从 GitHub Releases 下载可执行文件

macOS 用户

从 GitHub Releases 下载可执行文件

通过 Homebrew Cask 安装

你也可以通过 Homebrew cask 安装 SD Prompt Reader.

brew install --no-quarantine receyuki/sd-prompt-reader/sd-prompt-reader

使用 --no-quarantine 参数是因为目前 SD Prompt Reader 并未签名, 具体原因请查看这里

ComfyUI Prompt Reader Node

这是 SD Prompt Reader 的一个子项目。它帮助你从 SD Prompt Reader 支持的任何格式的图像中提取元数据,并保存带有额外元数据的图像,以确保与 Civitai 等网站上的元数据检测兼容。

Github Repo

安装说明

在 ComfyUI Manager 中搜索 SD Prompt Reader 并安装。

手动安装

请确保在安装主库的同时安装子模块。

cd 到 custom_node 文件夹- Clone 这个 repo

git clone --recursive https://github.com/receyuki/comfyui-prompt-reader-node.git

- 安装依赖

cd comfyui-prompt-reader-node pip install -r requirements.txt

]]>

]]>

]]>